Análise Léxica e o Papel das Expressões Regulares - Compiladores

- Descrição

- Currículo

- Revisões

Visão Geral do Curso: Compiladores – Análise Léxica e Expressões Regulares

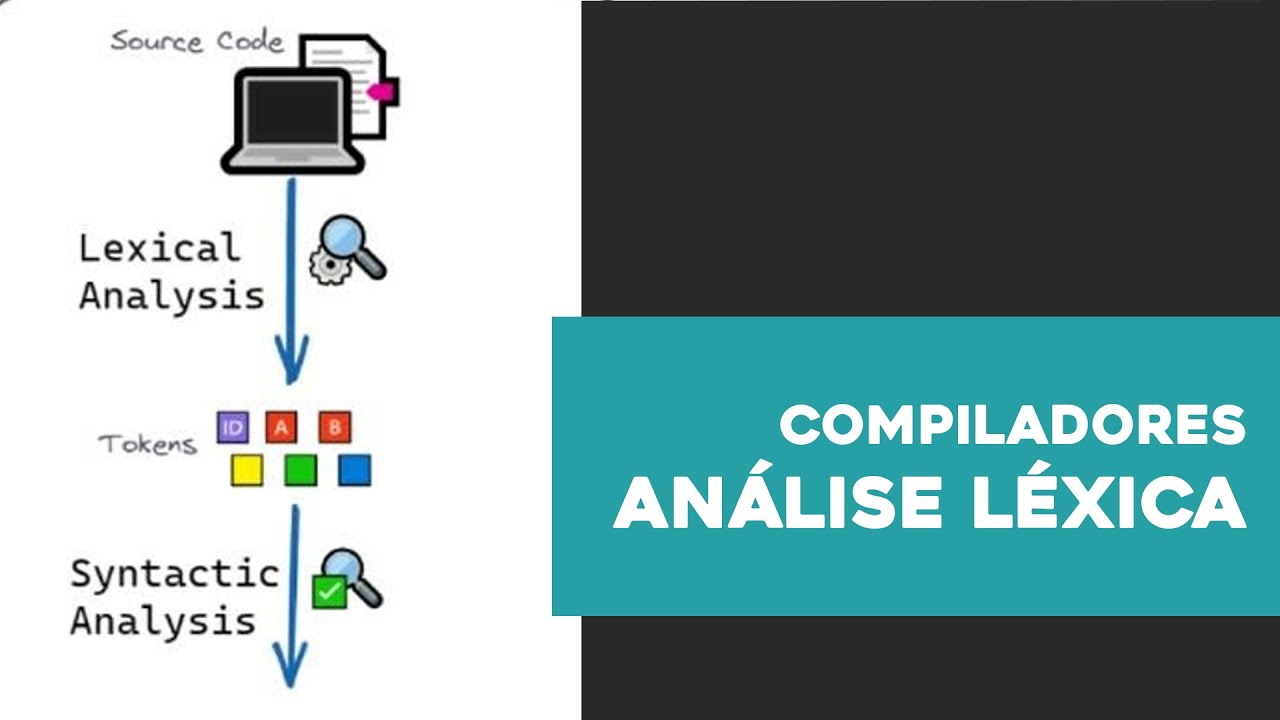

Este curso oferece uma introdução clara e completa à Análise Léxica, a primeira e mais crucial fase da compilação. Você vai aprender a transformar código-fonte (uma sequência de caracteres) em unidades lógicas chamadas tokens, a base para qualquer linguagem de programação.

Navegaremos pelos conceitos essenciais de tokens, lexemas e padrões, e aprofundaremos na teoria por trás deles, incluindo o poder das expressões regulares e o funcionamento dos autômatos finitos. Para conectar a teoria à prática, exploraremos o uso de ferramentas reais como Flex e ANTLR, que automatizam o processo de construção de analisadores.

Ao final, você terá uma compreensão sólida de como o computador “lê” e interpreta o código que escrevemos, dominando os alicerces da engenharia de software e do desenvolvimento de compiladores.

-

2Tokens

Tokens são as categorias ou tipos de elementos que o analisador léxico encontra no código-fonte. Eles representam unidades lógicas e indivisíveis, como palavras-chave, identificadores, operadores e literais. A principal função do analisador léxico é agrupar sequências de caracteres e classificá-las como um token.

-

3Lexemas

A aula descreve o conceito de lexema.

Um lexema é a sequência exata de caracteres no código-fonte que o analisador léxico encontra. Em termos mais simples, é o "valor" concreto que corresponde a um token.

-

4Padrões

A aula descreve o conceito de padrão na análise léxica.

Um padrão é uma regra, geralmente expressa por meio de expressões regulares, que define a forma de um token. Ele serve como uma "receita" para o analisador léxico saber o que procurar.

-

5Exemplos Práticos

Nesta aula, são apresentados exemplos sobre o conteúdo visto até o momento.

-

10Caso Prático Flex

A aula finaliza com um estudo de caso prático para consolidar os conceitos de análise léxica.

O objetivo é criar um analisador léxico para uma mini-linguagem de expressões aritméticas usando o Flex. Os tokens, como identificadores (

x), números (3) e operadores (+), são definidos através de expressões regulares.Ao processar o código

x = 3 + y;, o analisador lê a entrada e a converte em uma sequência de tokens lógicos. Esse processo simplifica a próxima etapa da compilação, que é a análise sintática. -

11Caso Prático ANTLR

A aula explica a abordagem do ANTLR, uma ferramenta que integra a análise léxica e sintática em um único arquivo de gramática (

.g4).No ANTLR, você define tanto as regras dos tokens (usando expressões regulares) quanto as regras para a estrutura das sentenças da linguagem. A ferramenta então gera um analisador completo que pode ser usado em várias linguagens de programação, como Java e Python.